안녕하세요! IT와 테크의 모든 것을 쉽고 깊이 있게 읽어주는 스마트리더입니다.

요즘 뉴스만 틀면 ‘엔비디아(NVIDIA)’ 이야기가 끊이지 않습니다. 주가는 하늘 높은 줄 모르게 치솟고, 전 세계 빅테크 기업들은 이 회사 칩을 구하지 못해 줄을 서고 있죠.

제가 엔비디아를 처음 접했던 건 1999년 무렵이었습니다. 당시 시장을 장악했던 ‘부두(Voodoo)’ 그래픽카드가 시장에서 사라지던 때였죠. 대안을 찾던 제 눈에 들어온 것이 바로 엔비디아의 ‘지포스(GeForce)’ 시리즈였습니다.

당시를 회상하면, 그때는 이 회사가 이렇게까지 최고의 빅테크 기업이 될 줄은 상상도 못 했습니다.

배틀그라운드나 롤(LoL)을 부드럽게 돌려주던 ‘게임용 부품’이, 도대체 어떻게 최첨단 인공지능(AI) 시대의 ‘심장’이 되었을까요? 그 흥미로운 이유를 지금부터 하나씩 짚어보겠습니다.

1. CPU vs GPU (천재 1명과 초등학생 1,000명의 대결)

AI가 그래픽카드를 선택한 이유를 알기 위해서는 먼저 컴퓨터의 두뇌인 CPU와 그래픽카드인 GPU의 차이를 알아야 합니다.

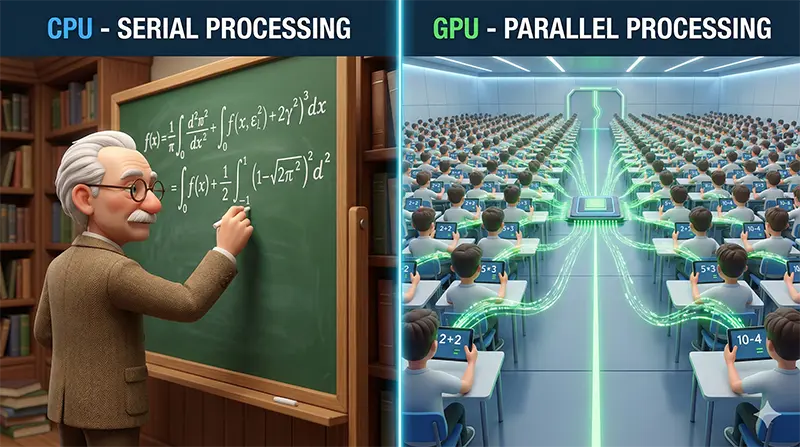

CPU: 똑똑한 수학 교수님 (직렬 처리)

컴퓨터의 메인 두뇌인 CPU는 ‘똑똑한 수학 교수님’ 1명과 같습니다. 미적분, 논리 판단 같은 아주 복잡하고 어려운 문제를 푸는 데는 선수지만, 한 번에 하나씩 순서대로 처리해야 합니다.

GPU: 단순한 초등학생 1,000명 (병렬 처리)

반면 그래픽카드(GPU)는 ‘단순 계산을 하는 초등학생’ 1,000명과 같습니다.

어려운 미적분은 못 풀지만, “1+1을 100만 번 풀어라” 같은 단순 반복 숙제는 교수님 1명보다 초등학생 1,000명이 동시에 달려드는 게 훨씬 빠르겠죠? 이것이 바로 ‘GPU 병렬 처리’의 핵심입니다.

2. 게임과 AI의 놀라운 평행이론 (숫자의 비밀)

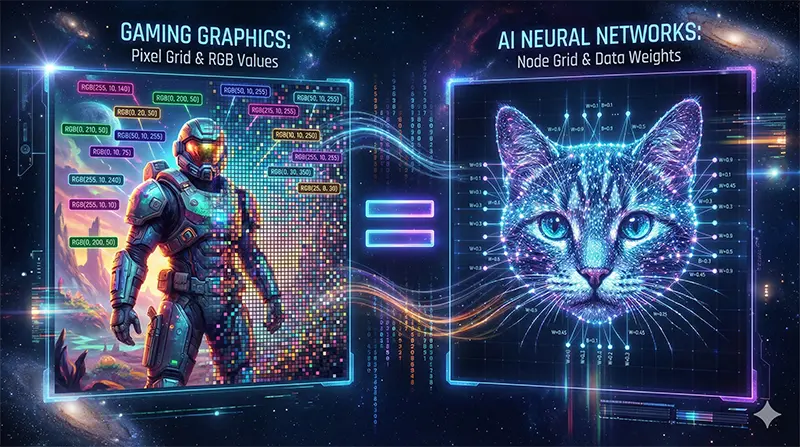

“그럼 그 단순 계산이 AI랑 무슨 상관인가요?”라고 물으실 수 있습니다. 놀랍게도 게임 화면을 그리는 원리와 AI가 공부하는 원리가 수학적으로 쌍둥이처럼 똑같습니다.

우리가 즐기는 게임 화면을 숫자로 한번 뜯어볼까요?

(1) 게임 그래픽 처리 과정 (단순 반복의 연속)

우리가 흔히 쓰는 FHD 모니터(1920×1080) 화면을 기준으로 생각해 봅시다.

- 픽셀 수: 화면에는 약 207만 개의 작은 점(픽셀)이 있습니다.

- 주사율(60Hz): 연속적인 화면 표현을 위해 이 점들을 1초에 60번 다시 그려야 합니다.

- 계산량: 각 점마다 빛의 각도, 그림자, 색상을 계산해야 하니, 초당 1억 2천만 번 이상의 단순 계산이 쉴 새 없이 쏟아집니다.

(2) 엔비디아 그래픽카드 AI 이미지 인식 과정

AI가 고양이 사진을 보고 학습하는 딥러닝 학습 과정도 이와 똑같습니다.

가로세로 1,000픽셀인 고양이 사진 한 장은 AI 입장에서 보면 100만 개의 숫자(1,000 픽셀 * 1,000 픽셀) 데이터 덩어리입니다.

AI가 이 사진 속 형체가 ‘고양이’인지 알아내려면, 100만 개의 픽셀 하나하나를 수억 개의 인공지능 변수(가중치)와 일일이 대조해야 합니다. 이 과정에서 수조 번의 곱하기와 더하기(행렬 연산)가 찰나의 순간에 일어납니다.

진짜 문제는 여기서 끝이 아닙니다. AI의 정확도를 높이려면 고양이 사진 1장으로는 부족하고 다양한 각도와 형태의 고양이 사진 100만 장 이상을 반복해서 학습시켜야 합니다.

즉, [100만 픽셀 * 수조 번의 연산 * 100만 장의 사진]이라는, 인간의 상상을 초월하는 계산량이 필요하게 된 것입니다.

3. 경쟁자가 넘볼 수 없는 ‘절대 해자’ 2가지

AMD나 인텔 같은 경쟁사들도 그래픽카드를 만듭니다. 그런데 왜 유독 전 세계 AI의 90% 이상이 엔비디아만 쓸까요?

“하드웨어만 보는 건 반쪽짜리 이해입니다.” 엔비디아의 진짜 힘은 칩이 아니라 그들을 둘러싼 생태계에 있습니다.

(1) CUDA(쿠다) → 개발자들의 ‘모국어’가 되다

엔비디아는 2006년, CUDA 플랫폼이라는 혁명적인 기술을 내놓았습니다. 이 CUDA 플랫폼 덕분에 개발자들은 GPU를 쉽게 제어할 수 있게 되었습니다.

GPU는 원래 복잡한 그래픽 명령어만 알아듣는 기계였습니다. 그런데 CUDA는 “누구나 쉽게 프로그래밍 언어(C언어 등)로 그래픽카드에 계산을 시킬 수 있게 해주는 번역기” 역할을 했습니다.

이게 15년 넘게 쌓이다 보니, 전 세계 AI 개발자들이 필수적으로 사용하는 인공지능 개발 도구(PyTorch, TensorFlow 등)들은 모두 CUDA를 표준으로 삼아 만들어졌습니다.

개발자들에게 엔비디아 칩을 쓰지 말라는 건, “지금부터 당신의 모국어를 쓰지 말고, 갑자기 낯선 외국어로 업무를 처리하세요”라고 하는 것과 같습니다.

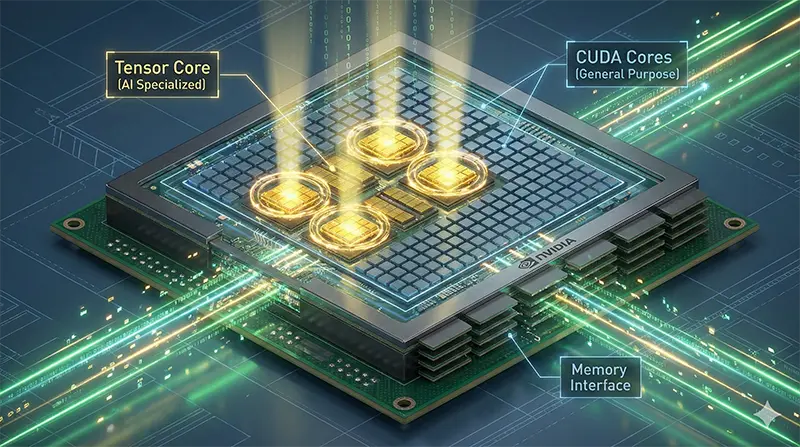

(2) 텐서 코어(Tensor Core)는 신의 한 수

엔비디아는 한술 더 떠서, 2017년부터 그래픽카드 안에 아예 AI 계산만 전담하는 ‘텐서 코어’라는 특수 부품을 집어넣기 시작했습니다.

- 일반 코어: 다용도 계산기 (게임도 하고 작업도 함)

- 텐서 코어: AI 전용 공학 계산기 (오직 AI 행렬 연산에만 몰빵)

“그럼 다른 회사도 텐서 코어 같은 걸 넣으면 되잖아요?”

맞습니다. 넣을 수 있습니다. 하지만 앞서 말한 CUDA(소프트웨어)가 텐서 코어(하드웨어)를 완벽하게 제어하고 있다는 점이 다릅니다.

경쟁사가 아무리 좋은 부품을 넣어도, 그걸 100% 활용할 CUDA와 같은 소프트웨어가 없으면 그냥 비싼 고철 덩어리에 불과하니까요.

4. 결국 ‘속도’보다 ‘효율’

AI 전쟁의 본질은 단순히 “누가 더 빠르냐”가 아닙니다.

“누가 더 많은 계산을, 더 싸게, 더 적은 전기로 처리하느냐”가 핵심입니다.

챗GPT 같은 거대 AI를 돌리는 데이터센터 입장에서는 전기세가 곧 비용입니다.

- 엔비디아 GPU는 텐서 코어 덕분에 같은 전기를 쓰고도 AI 연산을 수십 배 더 많이 처리합니다.

- 결국 기업 입장에서는 칩 가격이 조금 비싸더라도, 운영 비용(전기세, 시간)을 따져보면 엔비디아를 쓰는 게 가장 남는 장사인 셈이죠.

이것이 바로 구글, 테슬라, 메타 같은 빅테크 기업들이 자체 AI 칩을 개발하며 ‘독립’을 꿈꾸면서도, 여전히 천문학적인 돈을 들여 엔비디아 칩을 사재기하는 이유입니다.

아직은 엔비디아의 하드웨어 성능과 강력한 소프트웨어 생태계를 완벽히 대체할 대안이 없기 때문이죠.

💡 자주 묻는 질문 (FAQ)

📌 오늘 배운 내용 3줄 요약

오늘날 엔비디아의 독주는 한마디로 [하드웨어(텐서 코어) + 소프트웨어(CUDA) + 생태계(개발자)]라는 3박자가 15년 동안 단단하게 굳어진 결과입니다.

오늘의 IT 트렌드 이해, 도움이 되셨나요? 지금까지 스마트한 IT 길잡이, 스마트리더였습니다! 🚀